Вы когда-нибудь искали что-то в Google и задавались вопросом: «Как он узнает, где искать?» Ответ — «поисковые роботы», которые индексируют сайты, чтобы Вы могли легко находить нужные вещи в Интернете.

Поисковые системы и поисковые роботы

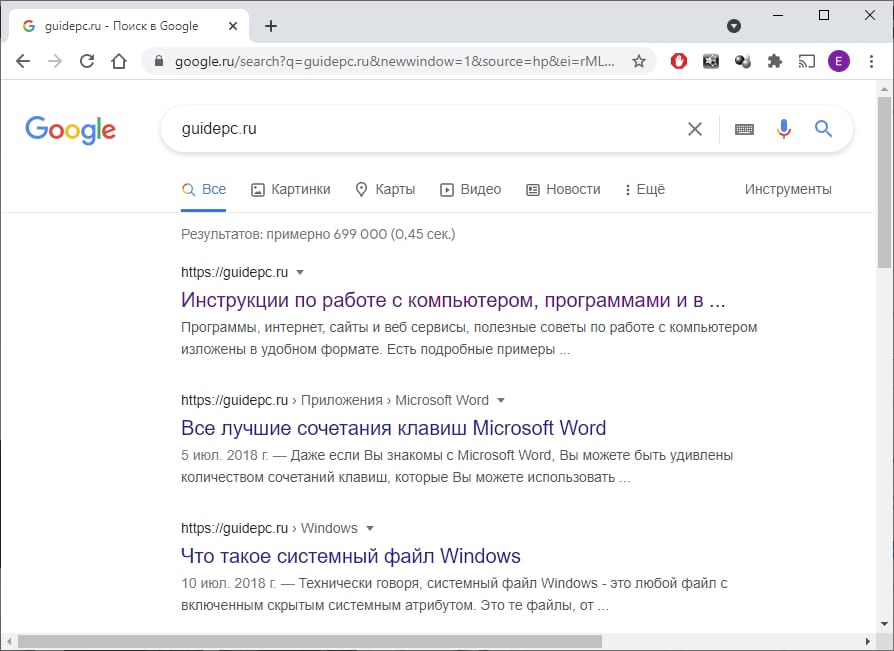

Когда Вы выполняете поиск по ключевому слову в такой поисковой системе, как Google или Яндекс, сайт просматривает триллионы страниц, чтобы сформировать список результатов, связанных с этим термином. Как именно эти поисковые системы хранят все эти страницы в файлах, знают, как их искать, и генерируют эти результаты в считанные секунды?

Ответ — поисковые роботы. Это автоматизированные программы (часто называемые «роботами» или «ботами»), которые «сканируют» или просматривают веб-страницы, чтобы их можно было добавить в поисковые системы. Эти роботы индексируют веб-сайты, чтобы создать список страниц, которые в конечном итоге появятся в Ваших результатах поиска.

Поисковые роботы также создают и хранят копии этих страниц в базе данных движка, что позволяет выполнять поиск практически мгновенно. Это также причина, по которой поисковые системы часто включают кешированные версии сайтов в свои базы данных.

Карты сайта и выбор

Итак, как сканеры выбирают, какие веб-сайты сканировать? Наиболее распространенный сценарий заключается в том, что владельцы веб-сайтов хотят, чтобы поисковые системы сканировали их сайты. Они могут добиться этого, попросив Google, Яндекс, Bing, Yahoo или другую поисковую систему проиндексировать свои страницы. Этот процесс варьируется от движка к движку. Кроме того, поисковые системы часто выбирают для сканирования популярные веб-сайты с хорошими ссылками, отслеживая, сколько раз URL ссылается на другие общедоступные сайты.

Владельцы веб-сайтов могут использовать определенные процессы, чтобы помочь поисковым системам индексировать свои веб-сайты, например, загрузка карты сайта. Это файл, содержащий все ссылки и страницы, которые являются частью Вашего веб-сайта. Обычно он используется, чтобы указать, какие страницы Вы хотите проиндексировать.

После того, как поисковые системы уже просканировали сайт один раз, они автоматически просканируют этот сайт снова. Частота варьируется в зависимости от того, насколько популярен веб-сайт, среди других показателей. Поэтому владельцы сайтов часто обновляют карты сайтов, чтобы системы знали, какие новые страницы нужно проиндексировать.

robots.txt

Что делать, если веб-сайт не хочет, чтобы некоторые или все его страницы отображались в поисковой системе? Например, Вы можете не захотеть, чтобы люди искали страницу только для вошедших пользователей или видели Вашу страницу с ошибкой 404. Здесь вступает в силу список исключений сканирования, также известный как robots.txt. Это простой текстовый файл, который указывает сканерам, какие веб-страницы исключить из индексации.

Еще одна причина важности файла robots.txt заключается в том, что поисковые роботы могут существенно повлиять на производительность сайта. Поскольку сканеры, по сути, загружают все страницы Вашего веб-сайта, они потребляют ресурсы и могут замедлять работу. Они приходят в непредсказуемое время и без одобрения. Если Вам не нужно повторно индексировать страницы, остановка поисковых роботов может помочь снизить нагрузку на Ваш сайт. К счастью, большинство поисковых роботов прекращают сканирование определенных страниц в соответствии с правилами владельца сайта.

Магия метаданных

Под URL-адресом и заголовком каждого результата поиска в Google Вы найдете краткое описание страницы. Эти описания называются фрагментами. Вы можете заметить, что фрагмент страницы в Google не всегда совпадает с фактическим содержанием веб-сайта. Это связано с тем, что на многих веб-сайтах есть так называемые «метатеги», которые представляют собой настраиваемые описания, которые владельцы сайтов добавляют на свои страницы.

Владельцы сайтов часто придумывают заманчивые описания метаданных, написанные для того, чтобы Вы захотели перейти на сайт. Google также показывает другую метаинформацию, такую как цены и наличие на складе. Это особенно полезно для тех, у кого есть сайты электронной коммерции.

Ваш поиск

Веб-поиск — важная часть использования Интернета. Поиск в Интернете — отличный способ обнаружить новые веб-сайты, магазины, сообщества и интересы. Каждый день поисковые роботы посещают миллионы страниц и добавляют их в поисковые системы. Хотя поисковые роботы имеют некоторые недостатки, например, занимают ресурсы сайта, они неоценимы как для владельцев сайтов, так и для посетителей.